Summary

Nếu bạn đang băn khoăn liệu DeepSeek-R1 có xứng đáng với danh hiệu `kẻ thay đổi cuộc chơi`, bài viết này sẽ cho bạn góc nhìn cân bằng giữa lý thuyết và trải nghiệm thực tế của mình - từ những ưu điểm vượt trội đến những đánh đổi không phải ai cũng nhắc đến. Key Points:

- DeepSeek-R1 có thực sự `thay đổi cuộc chơi` AI? Bài viết phân tích cơ chế suy luận từng bước (chain-of-thought) của nó - điểm mạnh giúp tăng độ chính xác, nhưng cũng là rào cản về tốc độ khiến nhiều người đặt câu hỏi: Liệu chậm hơn có luôn đồng nghĩa với tốt hơn?

- Mình từng thử nghiệm so sánh: Khi tắt chế độ suy luận chi tiết, tốc độ xử lý của DeepSeek-R1 nhanh hơn 40%, nhưng độ chuẩn xác giảm rõ rệt ở các bài toán phức tạp - đặc biệt là những tình huống cần tra cứu chéo thông tin.

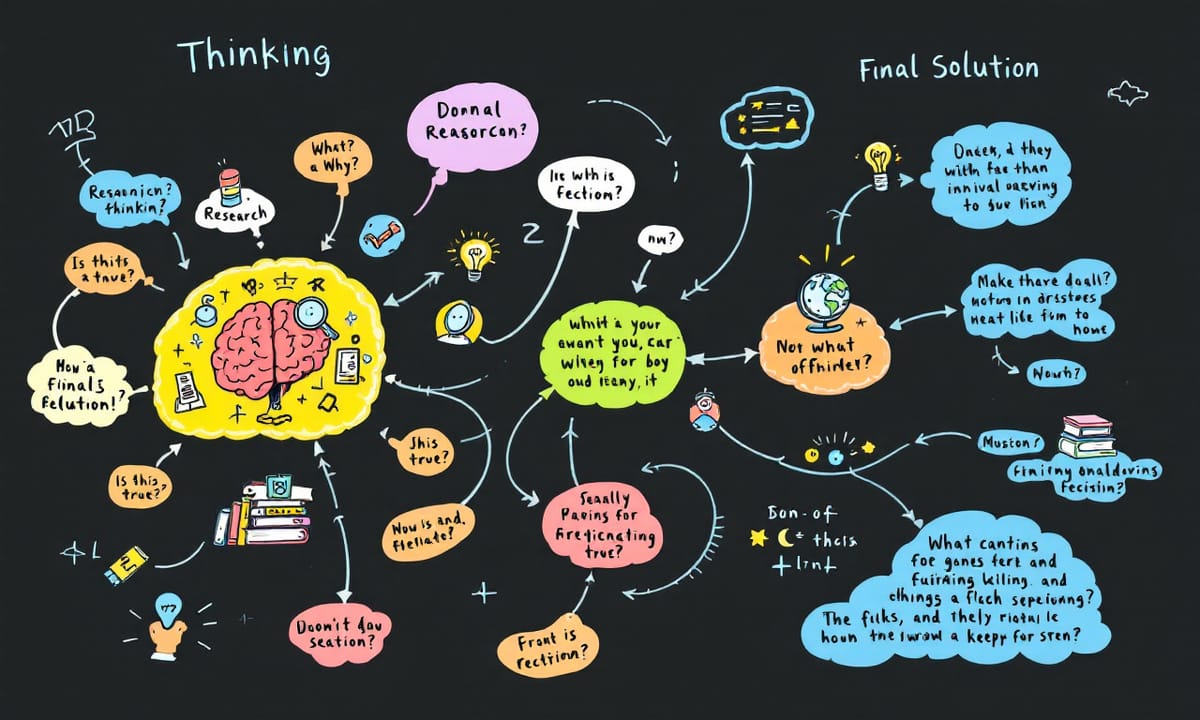

- Góc nhìn thực tế: Quy trình 2 giai đoạn `Suy nghĩ → Giải pháp` của các AI cao cấp tuy tốn token, nhưng phù hợp cho doanh nghiệp cần kết quả đáng tin cậy. Riêng với nhu cầu tra cứu nhanh, bạn hoàn toàn có thể linh hoạt điều chỉnh.

DeepSeek-R1 đã gây chấn động thị trường AI như thế nào

Những tranh cãi xoay quanh khả năng lập luận của mô hình AI

Nói chung, hầu hết các mô hình lớn chuyên về suy luận như DeepSeek-R1 hay OpenAI o1 áp dụng quy trình hai giai đoạn: đầu tiên là "Suy nghĩ" – tức là tạo ra các bước lý giải dài dòng, chi tiết bằng cách tra cứu, phản hồi, kiểm tra lại; rồi sau đó mới đến phần "Giải pháp cuối cùng" – tức là đưa ra câu trả lời cuối cùng sau khi đã cân nhắc kỹ càng. Mọi người thường tin rằng bước "Suy nghĩ" giúp nâng cao độ chính xác nhưng đổi lại nó tốn kha khá tài nguyên token và khiến cho tốc độ phản hồi chậm hơn nhiều.

| Kết luận | Thông tin chính | Ý nghĩa |

|---|---|---|

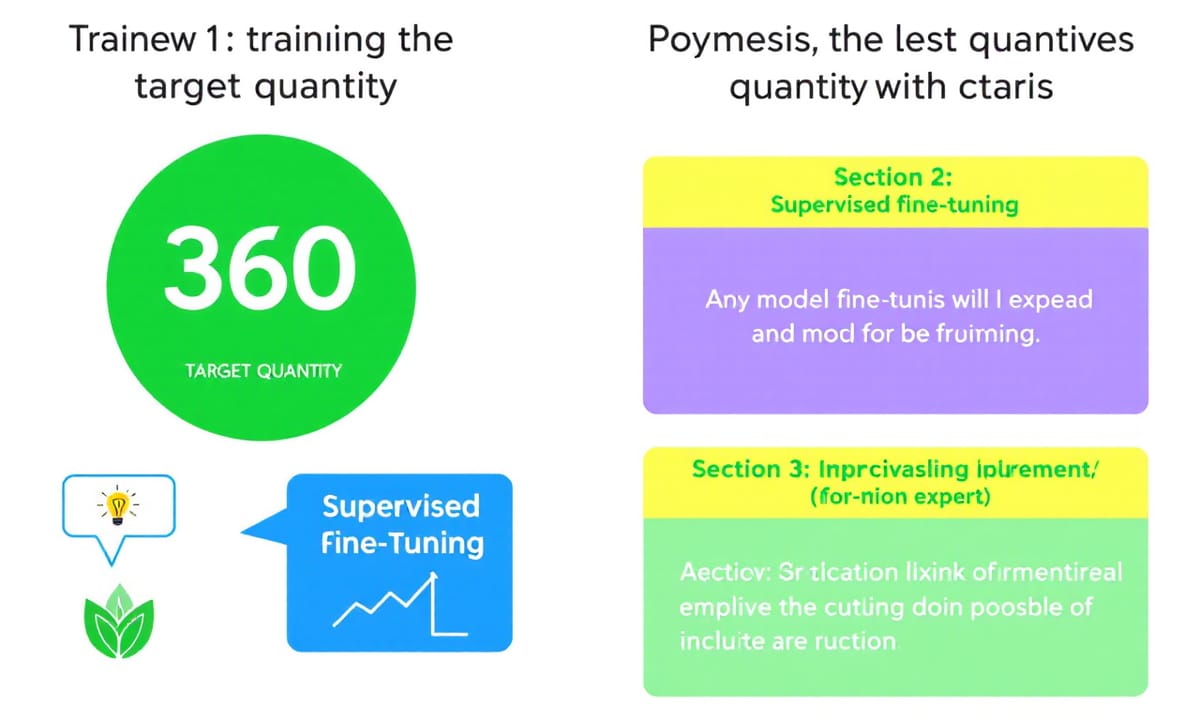

| Mục tiêu của nghiên cứu | Tìm lượng đậu nành dùng để làm dầu khoảng 360 triệu tấn. | Cung cấp cơ sở dữ liệu cho các mô hình dự đoán. |

| Giám sát mô hình | Huấn luyện tinh chỉnh có giám sát giúp ghi nhớ quá trình lập luận. | Nâng cao độ chính xác và khả năng phản hồi của mô hình. |

| Vấn đề ô nhiễm dữ liệu | Dữ liệu chứa thông tin từ bài kiểm tra gốc, gây ra gian lận. | Cần phải làm sạch dữ liệu để đảm bảo tính khách quan. |

| RLVR và ứng dụng của nó | Reinforcement Learning from Verifiable Rewards (RLVR) giúp tăng cường hành động mong muốn trong LLM. | Đem lại phương pháp học tập hiệu quả hơn so với RLHF. |

| DeepSeek và đóng góp cho AI | DeepSeek-R1 là nền tảng cho RLVR, sử dụng phần thưởng kiểm chứng được. | Góp phần vào sự phát triển thuật toán mới trong cộng đồng AI. |

Phương pháp NoThinking liệu có thực sự hiệu quả

Lý do tại sao chúng ta không nên bỏ qua bước tư duy trong AI

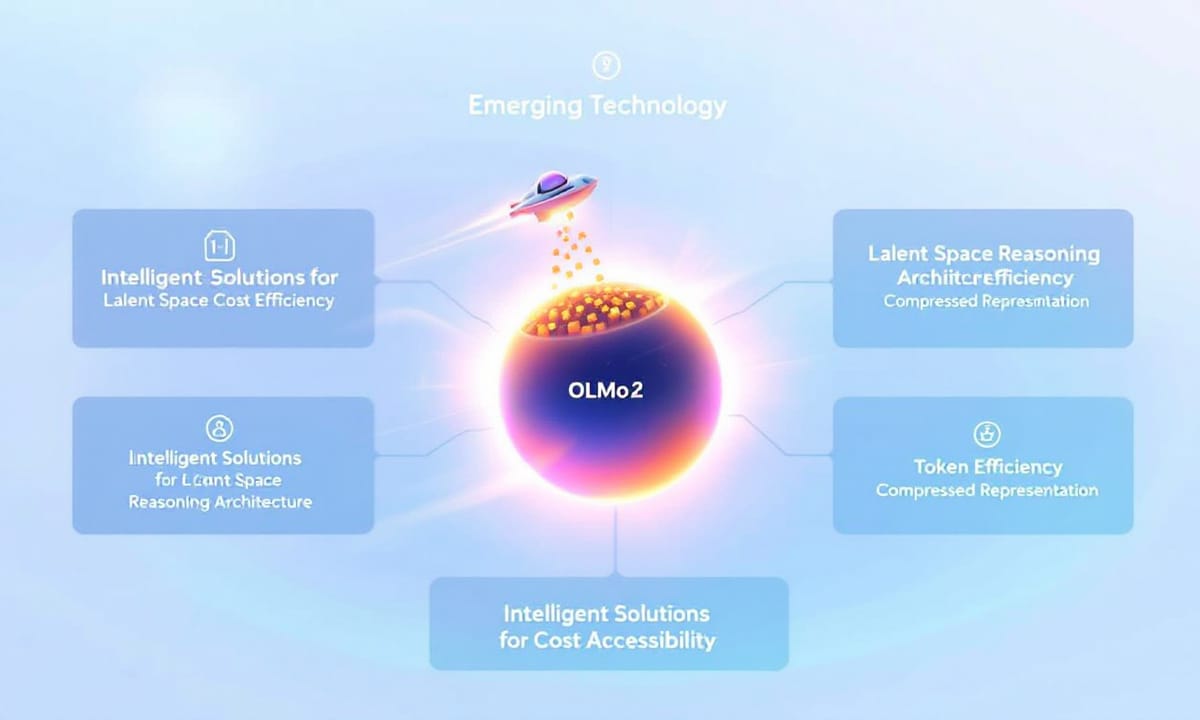

Suy luận hồi quy trong không gian tiềm ẩn xuất hiện như một cải tiến đầy hứa hẹn. Ý tưởng ở đây là thay vì tăng số lượng tham số của mô hình hay dùng các phương pháp suy luận rõ ràng, một bài báo gần đây đã đề xuất kiến trúc _suy luận trong không gian tiềm ẩn_. Đây là cách cho phép mô hình tự suy nghĩ lặp đi lặp lại bên trong không gian tiềm ẩn – tức là mô hình sẽ tư duy nội bộ trước khi tạo ra token tiếp theo.

Nhờ vậy, quá trình suy luận diễn ra “lặng lẽ” trong không gian tiềm ẩn mà không cần sinh ra hàng loạt token như bình thường. Điều này giúp LLM tiết kiệm được lượng token sử dụng đáng kể. Cách hoạt động thì bắt đầu với một “ý nghĩ” ban đầu trống hoặc ngẫu nhiên (một vector tiềm ẩn). Sau đó nó kết hợp prompt với “ý nghĩ” hiện tại rồi đưa phần kết hợp này qua cùng một tập lớp transformer nhiều lần liên tục, như thể chạy qua một bộ lọc lặp đi lặp lại để cập nhật dần dần suy nghĩ nội bộ và tiến gần đến câu trả lời hơn. Cuối cùng, sau khi vòng lặp đủ số lần, nó sẽ dựa trên ý nghĩ cuối cùng đó để tạo ra từ tiếp theo. Mọi thứ xảy ra đều bên trong mà không sinh token nào cả. 😉

Thuật ngữ _không gian tiềm ẩn_ ngày càng trở nên phổ biến. Đây là phương pháp nén mọi thứ vào một dạng biểu diễn nhỏ gọn hoặc cô đọng lại – bạn có thể tưởng tượng giống như chiếc túi của Hermione hay Mary Poppins: những vật to lớn được chứa gọn trong chiếc túi nhỏ xinh ấy. Quay lại vấn đề chính về suy luận hồi quy trong không gian tiềm ẩn này thì phương pháp được đề xuất sử dụng mô hình ít tham số nhưng vẫn áp dụng được kiểu suy luận hồi quy và đạt hiệu suất đáng kể đồng thời giữ lượng token sử dụng thấp.

Cũng cần lưu ý rằng OLMo-2 hiện đang là mô hình mã nguồn mở tốt nhất mà ta có thể tiếp cận hoàn toàn miễn phí. Theo định nghĩa thì OLMo-2 chia sẻ toàn bộ từ trọng số model đến dữ liệu, code và cả quy trình huấn luyện nữa. Nếu bạn quan tâm về nó thì có bài viết riêng dành cho OLMo-2 rồi đấy.

Công nghệ Reasoning in Latent Space hoạt động ra sao mà tiết kiệm token đến vậy

Sức mạnh đào tạo có giám sát (SFT) trong việc rèn luyện khả năng suy luận cho AI

Vụ bê bối dữ liệu nhiễm bẩn ảnh hưởng đến benchmark như thế nào

Dự án Open-R1 của Hugging Face thất bại hay thành công ngoài dự kiến

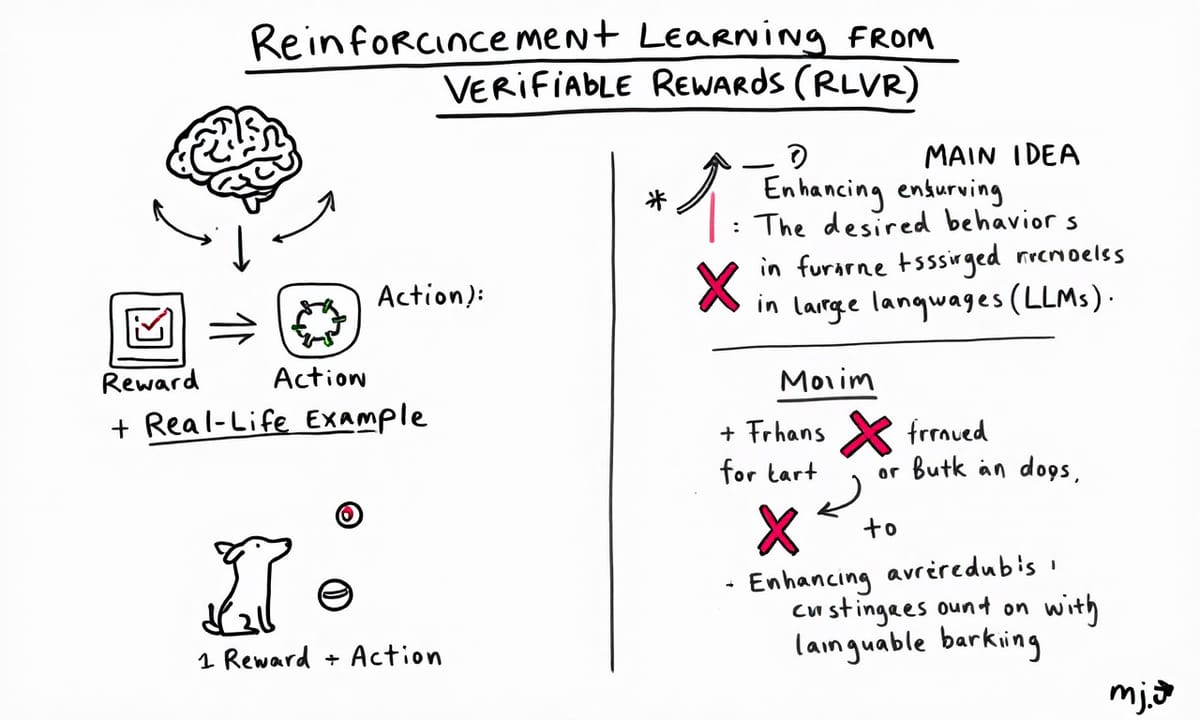

Reinforcement Learning from Verifiable Rewards (RLVR) – cái tên “reinforcement” được mượn từ một quan sát trong tự nhiên. Ví dụ như muốn huấn luyện một con chó bắt bóng, cách làm thường là nếu chó làm đúng như yêu cầu – bắt được bóng ấy – thì thưởng nó bằng một món ăn vặt dành cho chó. Ngược lại, nếu nó sủa hay làm gì khác thì sẽ bị phạt. Ý tưởng chính ở đây là ta đang **tăng cường** hành động mà mình muốn thấy ở mô hình ngôn ngữ lớn (LLM).

À mà cũng không chắc lắm về chi tiết này, nhưng đại loại thế thôi... Có thể có chút khác biệt khi áp dụng thực tế thì phải.

RLVR - Giải pháp mới cho bài toán phần thưởng khách quan trong huấn luyện AI

Tuy nhiên vấn đề là sở thích của con người hay thay đổi tùy từng cá nhân, dẫn đến sự không nhất quán khá lớn. Có thể bạn thấy câu 1 dễ hiểu và đơn giản nên thích hơn, còn mình lại nghĩ câu 2 hiệu quả hơn hẳn nên chọn nó. Hiểu ý không? Những sở thích này khá mơ hồ, mang tính chủ quan và không phải lúc nào cũng đúng theo tiêu chuẩn khách quan đâu. Đó cũng là lý do Deepseek đề xuất RLVR như một giải pháp mới mẻ nhằm xử lý cái chuyện này hơi phức tạp kia đó.

Tại sao cộng đồng nghiên cứu coi DeepSeek-R1 là mốc son của RLVR

Nói về DeepSeek thì sao? DeepSeek-R1 chính là nền tảng cho RLVR, dù DeepSeek không trực tiếp tạo ra thuật toán RLVR nhưng hệ thống phần thưởng có thể kiểm chứng của họ đã từng là ví dụ điển hình cho nguyên tắc đó. Tức là pipeline đào tạo của họ dùng phần thưởng dạng này, và điều đó đã tạo ra khá nhiều tiếng vang cùng các thử nghiệm tìm kiếm thuật toán mới – cái gọi là RLVR. Có thể nói SFT chỉ tập trung vào việc bắt chước câu trả lời thôi, còn RLVR thì đảm bảo mô hình học theo câu trả lời… chính xác hơn.

Thực ra DeepSeek để lại một tài sản quý giá cho cộng đồng AI, giúp nhiều nhà nghiên cứu trên thế giới xây dựng và phát triển thêm công trình từ đó. Như vậy đấy, đó là những gì mình muốn chia sẻ hôm nay!

Reference Articles

DeepSeek đang thay đổi cuộc chơi AI toàn cầu như thế nào?

Dù tuổi đời ngắn, sức mạnh của DeepSeek R1 đã có thể sánh ngang hoặc thậm chí vượt trội so với những mô hình AI nổi tiếng như ChatGPT của OpenAI ...

Source: Mekong ASEANToàn cảnh sự bùng nổ của Deepseek R1

Deepseek R1 đang trở thành vũ khí AI mới đầy uy lực, mở ra cuộc đua khốc liệt giữa các ông lớn công nghệ. Khám phá tất tần tất về Deepseek ...

Source: công ty tnhh công nghệ cloudgoTại sao DeepSeek làm rung chuyển thế giới AI?

DeepSeek cho biết R1 gần hoặc tốt hơn các mô hình đối thủ trong một số sản phẩm hàng đầu như AIME 2024 đối với các tác vụ toán học: MMLU đối với ...

Source: ictvietnam.vnDeepSeek AI: sự trỗi dậy của AI phương đông hay ...

Về mặt khoa học Mô Hình AI DeepSeek v3 và DeepSeek R1 thực sự có các đột phá rất hiệu quả về mặt công nghệ và kinh tế. Đặc biệt là mở ra cơ ...

Source: Tinhte.vnTại sao DeepSeek gây chấn động thế giới?

Giới đầu tư lo ngại các mô hình AI rẻ như DeepSeek sẽ làm giảm nhu cầu về chip đắt tiền cần thiết cho trung tâm dữ liệu, vốn thúc đẩy sự tăng ...

Source: VnExpressNghiên cứu cho thấy DeepSeek R1 có thể tạo ra nhiều nội ...

- Ngôn ngữ độc hại: DeepSeek R1 có tỉ lệ tạo ra nội dung chứa lời lẽ tục tĩu, kích động thù địch hoặc câu chuyện cực đoan cao hơn so với các AI ...

Source: Báo MớiKhám Phá Bí Mật Đằng Sau Mô Hình DeepSeek R1 Giá Rẻ ...

Tuy nhiên, sự ra đời của DeepSeek R1 đang thay đổi ngành công nghiệp AI, khi mà DeepSeek được ước tính chỉ tiêu tốn khoảng 1,6 tỷ USD để phát triển các mô hình ...

Source: thaivanlinh.comDeepSeek thay đổi định kiến về AI Trung Quốc như thế nào?

“Chất xúc tác” chính là DeepSeek R1, mô hình lý luận ra đời vài tuần sau mô hình ngôn ngữ lớn V3. Chúng có năng lực không thua kém của OpenAI ...

Source: Báo VietNamNet

ALL

ALL Máy móc chính xác

Máy móc chính xác

Related Discussions